Ollama 是一个便于本地部署和运行大型语言模型(Large Language Models, LLMs)的工具。

本文将介绍如何使用 Docker 安装和使用 Ollama 和 Open WebUI,并下载模型进行使用。

没有Docker的话,只需要安装 Python后,用 pip 命令照样可以安装 Open Webui,再下载模型,同样也可以用。

Ollama Docker 安装

开源的大型语言模型平台 Ollama 提供了强大的模型管理功能,允许用户下载、上传和管理各种预训练的语言模型。用户可以根据自己的需求选择合适的模型,并进行定制化配置。

Ollama项目在Github上 目前有 91.1k的星。

官网:https://ollama.com/

模型:https://ollama.com/library

Github:https://github.com/ollama/ollama

Docker:https://hub.docker.com/r/ollama/ollama/tags

1 | # 1.拉取 Ollama Docker 镜像 |

完成第2步后,打开浏览器,访问 http://localhost:11434,可以看到 Ollama is running 在运行了。

运行第3步后,等待模型下载完成,就直接可以使用该模型聊天了。(第一次没有该模型会自动下载该模型)

在模型页面上可以查看自己需要下载的模型。

Open WebUI Docker 安装

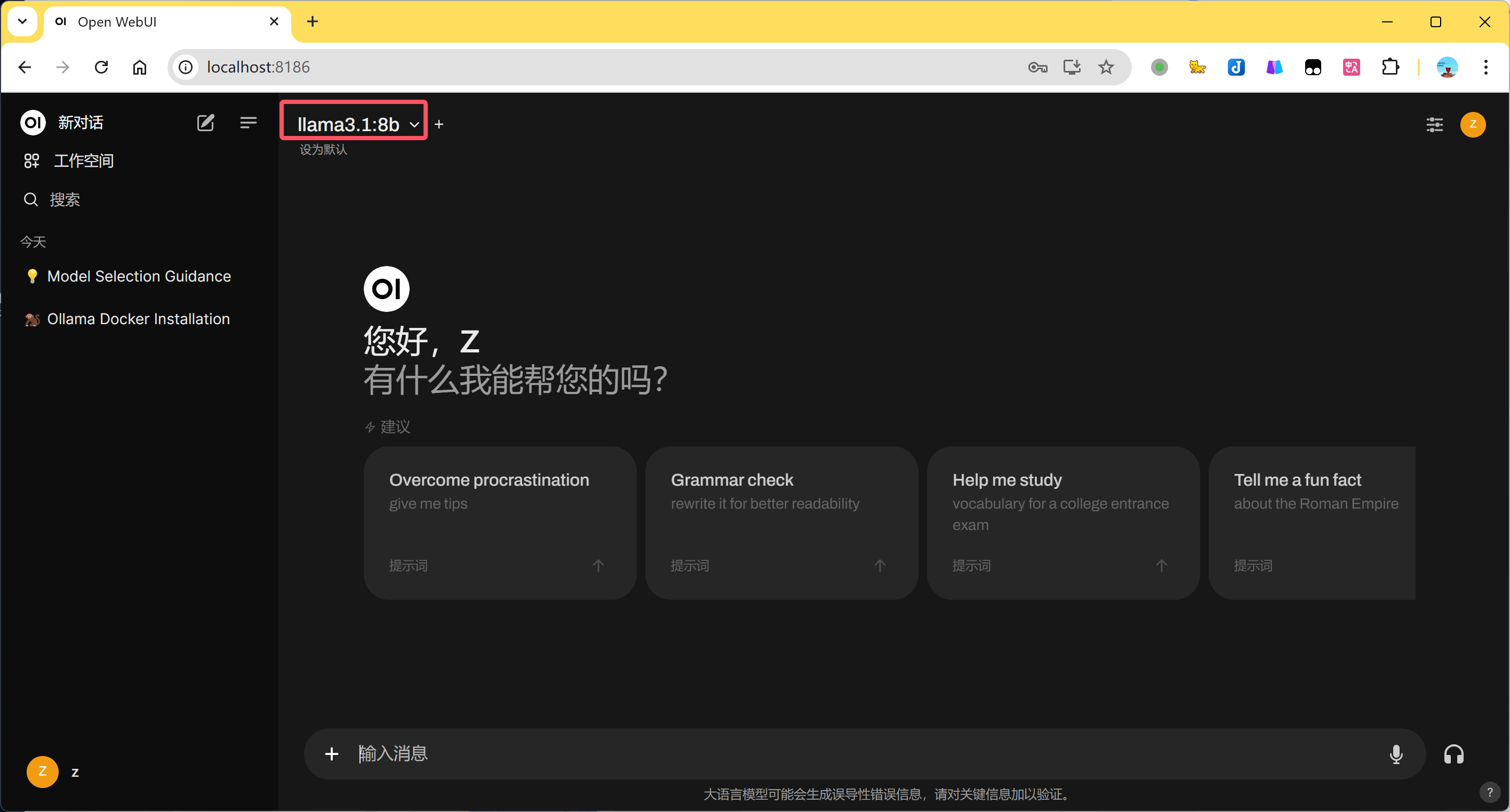

Open WebUI 是一种可扩展的、功能丰富且用户友好的自托管 WebUI,旨在完全离线运行。它支持各种LLM运行器,包括 Ollama 和与 OpenAI 兼容的 API。

该项目在Github上 目前有 40.6k的星。

Github:https://github.com/open-webui/open-webui

文档:https://docs.openwebui.com/

1 | # 1.拉取镜像 |

完成第2步后,打开浏览器,访问 http://localhost:8080,即可开始使用 Open WebUI。用邮箱注册下就可以了。

如果没有下载模型需要先下载模型,如果前面在ollama上下载过了,这里直接就选择模型就能用了。

pip 命令安装使用 Open Webui

安装过 Python的话,没有Docker也可以用。直接用 pip 命令安装 OpenWebui后,直接在上面下载模型就行。

1 | # 安装 |

打开浏览器,访问 http://localhost:8080

然后是可以下载模型的。去模型页面上看 https://ollama.com/library 然后比如要下载 llama3.1:8b 写上就能下载了。

- 本文标题:Ollama+OpenWebui搭建本地大模型(Docker版)

- 本文作者:HDUZN

- 创建时间:2024-09-28 13:32:11

- 本文链接:http://hduzn.cn/2024/09/28/Ollama-OpenWebui搭建本地大模型-Docker版/

- 版权声明:本博客所有文章除特别声明外,均采用 BY-NC-SA 许可协议。转载请注明出处!